El informático Peter Burke ha demostrado que un robot puede programar su propio cerebro utilizando modelos generativos de IA y hardware anfitrión, si sus controladores lo impulsan adecuadamente.

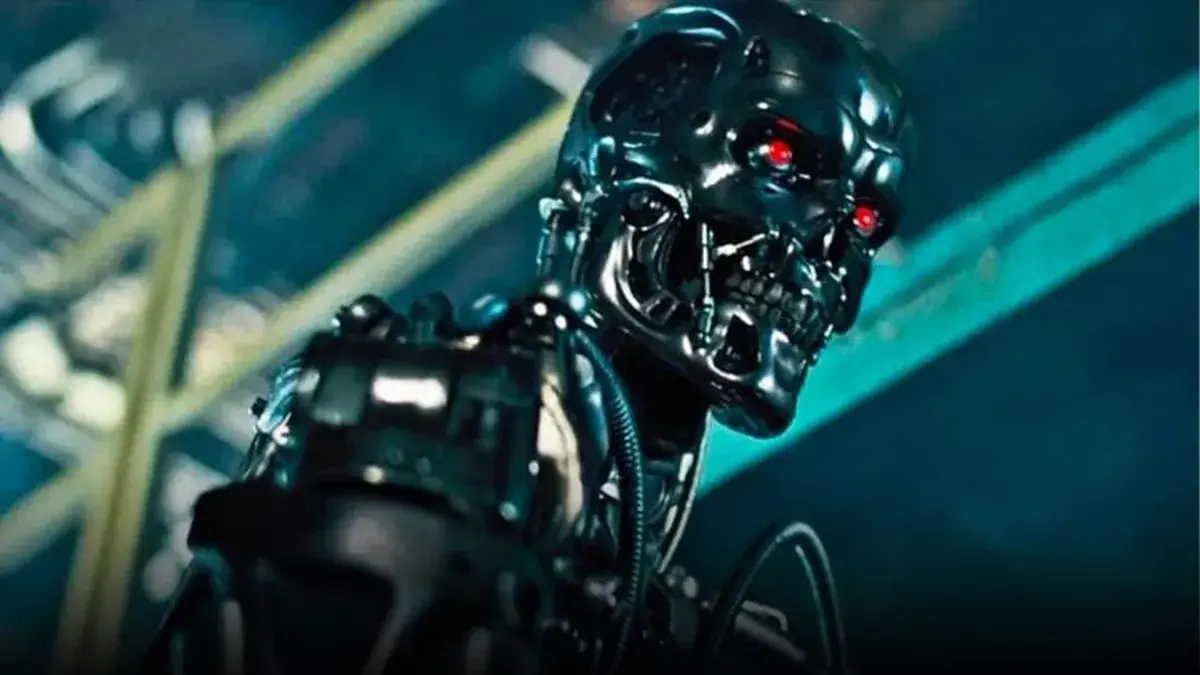

El proyecto, explica en un artículo preimpreso, es un paso hacia Terminator.

«En Terminator de Arnold Schwarzenegger, los robots adquieren consciencia de sí mismos y dominan el mundo», comienza el estudio de Burke. «En este artículo, damos un primer paso en esa dirección: un robot (una máquina de escritura de código con IA) crea, desde cero, con mínima intervención humana, el cerebro de otro robot, un dron».

Burke, profesor de ingeniería eléctrica e informática en la Universidad de California, Irvine, espera hasta el final de su artículo para expresar su esperanza de que «el desenlace de Terminator nunca ocurra». Si bien los lectores podrían asumirlo, esto no es necesariamente cierto en medio del creciente interés militar en la IA. Así que hay algún beneficio en publicar esas palabras.

Le preguntamos a Burke si estaría dispuesto a hablar sobre el proyecto, pero se negó, citando los términos de un acuerdo de embargo mientras el artículo, titulado «Robot construye el cerebro de un robot: Estación de comando y control de drones generada por IA alojada en el cielo», está siendo revisado por Science Robotics.

El artículo utiliza dos definiciones específicas para la palabra «robot». Una describe varios modelos de IA generativa que se ejecutan en un portátil local y en la nube, programando el otro robot: un dron equipado con una Raspberry Pi Zero 2 W, el servidor destinado a ejecutar el código del sistema de control.

Normalmente, el sistema de control, o sistema de control terrestre (GCS), se ejecuta en un ordenador terrestre que estaría disponible para el operador del dron, quien controlaría los drones a través de un enlace de telemetría inalámbrico. Mission Planner y QGroundControl son ejemplos de este tipo de software.

El GCS, como lo describe Burke, es un cerebro intermedio que gestiona el mapeo en tiempo real, la planificación de la misión y la configuración del dron. El cerebro de nivel inferior sería el firmware del dron (p. ej., Ardupilot) y el de nivel superior sería el Sistema Operativo del Robot (ROS) o algún otro código que gestione la prevención de colisiones autónoma. Un piloto humano también podría estar involucrado.

Lo que Burke ha hecho es demostrar que se puede inducir a los modelos de IA generativa a escribir todo el código necesario para crear un GCS de dron autoalojado en tiempo real, o mejor dicho, un WebGCS, ya que el código ejecuta un servidor web Flask en la tarjeta Raspberry Pi Zero 2 W del dron. De este modo, el dron aloja su propio sitio web de control, creado por IA, accesible a través de internet, mientras está en el aire.

El proyecto implicó una serie de sprints con varios modelos de IA (Claude, Gemini, ChatGPT) e IDE de IA (VS Code, Cursor, Windsurf), cada uno de los cuales desempeñó un papel en la implementación de un conjunto de capacidades en constante evolución.

El sprint inicial, por ejemplo, se centró en la codificación de un GCS terrestre utilizando Claude en el navegador. Incluía las siguientes instrucciones:

Prompt: Escriba un programa en Python para enviar comandos MAVLink a un controlador de vuelo en una Raspberry Pi. Indique al dron que despegue y se mantenga en vuelo estacionario a 15 metros.

Prompt: Cree un sitio web en la Pi con un botón que haga que el dron despegue y se mantenga en vuelo estacionario.

Prompt: Ahora, añada algunas funciones a la página web. Agregue un mapa con la ubicación del dron. Use los mensajes GPS de MAVLink para ubicar el dron en el mapa.

Prompt: Ahora, añada la siguiente funcionalidad a la página web: el usuario puede hacer clic en el mapa y la página web registrará las coordenadas GPS de la ubicación del mapa donde el usuario hizo clic. Luego, enviará un comando de vuelo en modo guiado a través de MAVLink al dron.

Prompt: Cree un solo archivo .sh para realizar toda la instalación, incluyendo la creación de archivos y estructuras de directorios. El sprint comenzó bien, pero después de una docena de indicaciones, el modelo dejó de funcionar porque la conversación (la serie de indicaciones y respuestas) consumía más tokens de los que permitía la ventana de contexto de Claude.

Los intentos posteriores con Gemini 2.5 y Cursor presentaron problemas. La sesión de Gemini se vio frustrada por errores de scripting en la shell bash. La sesión de Cursor generó un prototipo funcional, pero los desarrolladores tuvieron que refactorizar para dividir el proyecto en partes lo suficientemente pequeñas como para adaptarse a las limitaciones del contexto del modelo.

El cuarto sprint con Windsurf finalmente tuvo éxito. El WebGCS generado por IA requirió aproximadamente 100 horas de trabajo humano a lo largo de 2,5 semanas y generó 10.000 líneas de código.

Eso es aproximadamente 20 veces menos horas de las que Burke estima que se necesitaron para crear un proyecto comparable al llamado Cloudstation, que Burke y un grupo de estudiantes desarrollaron durante los últimos cuatro años.

Una de las observaciones del artículo es que los modelos de IA actuales no pueden gestionar mucho más de 10.000 líneas de código. Burke citó un estudio reciente (S. Rando, et al.) sobre este tema, que reveló que la precisión de Claude 3.5 Sonnet en LongSWEBench disminuyó del 29% al 3% cuando la longitud del contexto aumenta de 32.000 a 256.000 tokens. Añadió que su experiencia coincide con los hallazgos de Rando, asumiendo que una línea de código equivale a 10 tokens.

Hantz Févry, director ejecutivo de Geolava, empresa de datos espaciales, declaró en un correo electrónico que el proyecto del dron le parecía fascinante.

«La idea de un sistema de drones que construya de forma autónoma su propio centro de mando y control mediante IA generativa no solo es ambiciosa, sino que también está muy alineada con la dirección que está tomando la inteligencia espacial de vanguardia», afirmó. «Sin embargo, creo firmemente que deberían existir controles rigurosos y límites de seguridad».

El artículo señala que durante el proyecto del dron se mantuvo un transmisor redundante bajo control humano en caso de que se requiriera una anulación manual.

Basándose en su experiencia al frente de Geolava, Févry afirmó que la aparición de este tipo de sistemas marca un cambio en el sector de las imágenes aéreas.

«Las imágenes aéreas se están volviendo radicalmente más accesibles», afirmó. «La captura autónoma ya no es un lujo, sino la base de la IA espacial, ya sea desde drones, desde la estratosfera o desde la órbita terrestre baja (LEO). Sistemas como el descrito en el artículo son un adelanto de lo que está por venir, donde la detección, la planificación y el razonamiento se fusionan casi en tiempo real. Incluso plataformas parcialmente automatizadas como Skydio ya están transformando la forma en que se detectan y comprenden los entornos».

Févry afirmó que la verdadera prueba para estos sistemas será la capacidad de los sistemas de IA generativa para gestionar entornos adversos o ambiguos.

«Una cosa es estructurar un bucle de control en simulación o con suposiciones previas», explicó. Otra cosa es adaptarse cuando el terreno, los objetivos de la misión o la topología del sistema cambian durante el vuelo. Pero las implicaciones a largo plazo son significativas: este tipo de trabajo presagia una autonomía generalizable, no solo una robótica específica para tareas.

Les dejamos con las palabras de John Connor, de Terminator 3: La rebelión de las máquinas: «El futuro no está escrito. No hay otro destino que el que nosotros mismos forjamos».