La adopción de la inteligencia artificial (IA) en el entorno laboral se está acelerando a un ritmo mayor que el que la mayoría de las organizaciones pueden asegurar, lo que hace que el uso de los empleados sea cada vez más descontrolado y arriesgado.

Según un nuevo estudio de Cyberhaven, empresa de seguridad de datos basada en IA, casi el 40% de las interacciones de los empleados con herramientas de IA ahora involucran datos corporativos confidenciales. A medida que los trabajadores evitan los canales oficiales para utilizar herramientas especializadas como Claude y DeepSeek, las organizaciones se encuentran divididas entre los usuarios pioneros y los rezagados, que están perdiendo el control sobre sus activos de información más valiosos.

Cyberhaven Labs, el equipo de investigación interno de la compañía, publicó sus hallazgos el jueves, basados en el seguimiento del linaje de datos que rastrea cómo se mueve la información entre endpoints, aplicaciones SaaS y herramientas de IA en tiempo real. En muchos casos, las empresas priorizan el crecimiento y la experimentación. A continuación, la seguridad, la gobernanza y la supervisión.

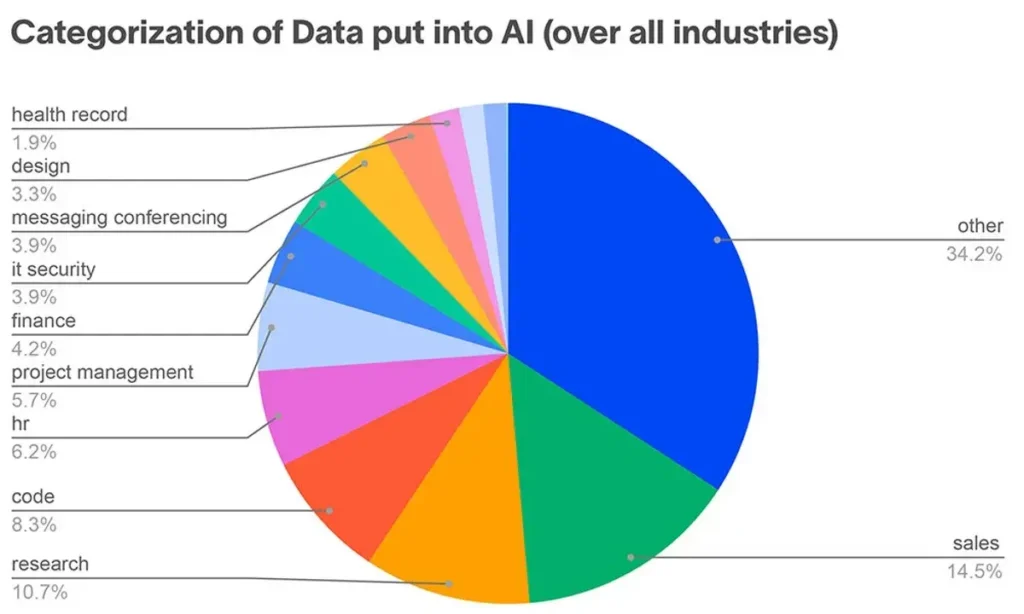

Al mismo tiempo, la mayor parte del uso de la IA actual se produce en herramientas que conllevan un riesgo elevado. Los empleados ingresan rutinariamente datos confidenciales en un vasto y creciente ecosistema de herramientas GenAI, asistentes de programación y agentes personalizados.

Para muchas organizaciones, el uso de la IA es una especie de lejano oeste, según el informe. Las herramientas proliferan más rápido que las políticas, el uso por parte de los empleados a menudo supera la visibilidad y los datos confidenciales fluyen entre modelos, aplicaciones y cuentas con un control centralizado limitado.

“Cada vez es más difícil asegurar el uso generalizado de herramientas, pero lo que las organizaciones pueden y deben hacer es garantizar que sus soluciones de seguridad de datos incluyan el uso de IA”, declaró Nishant Doshi, director ejecutivo de Cyberhaven.

La proliferación de herramientas de IA inunda las redes empresariales.

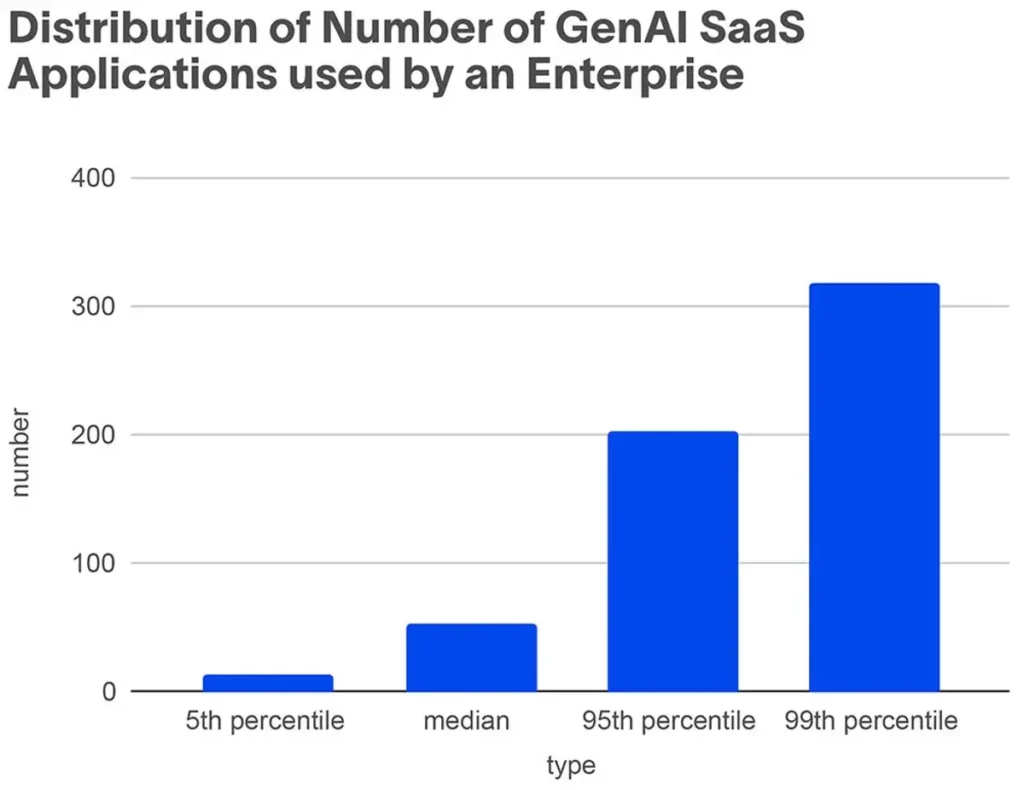

Un pequeño grupo de organizaciones fronterizas implementa agresivamente cientos de herramientas para casi el 70% de su plantilla. Las rezagadas se mantienen estancadas en un 2% de adopción. Esta brecha está creando un vacío donde los empleados, impulsados por las demandas de productividad, están eludiendo las barreras corporativas para construir sus propios ecosistemas de IA en la sombra.

El estudio de Cyberhaven presenta cinco hallazgos principales:

- Las organizaciones con las tasas más altas de adopción de IA utilizan más de 300 herramientas GenAI en su entorno empresarial.

- Los modelos chinos de peso abierto son ahora los favoritos de las empresas, representando la mitad del uso basado en endpoints entre los usuarios de Cyberhaven.

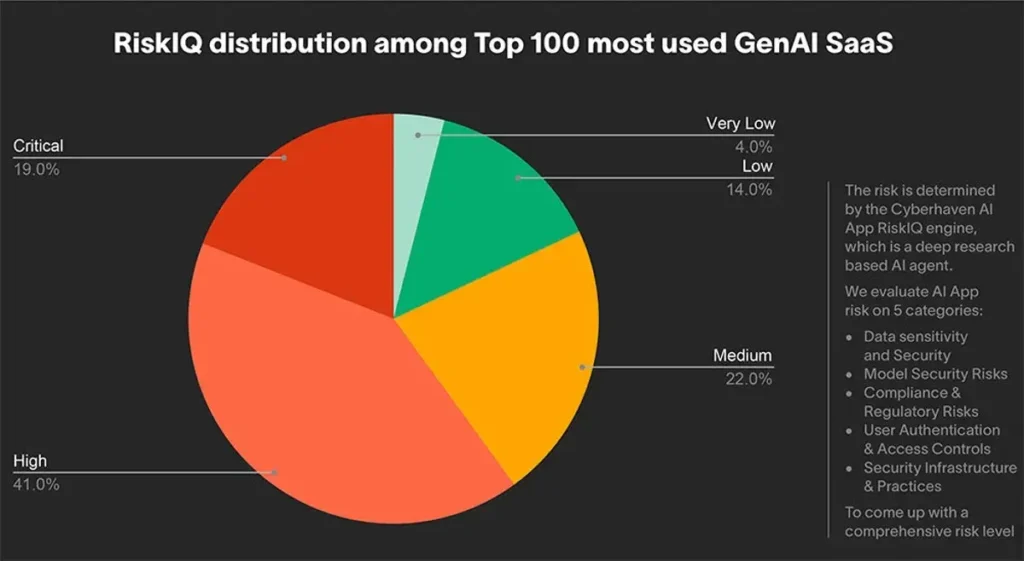

- Las herramientas GenAI siguen siendo riesgosas en todos los ámbitos. Al analizar las 100 aplicaciones SaaS GenAI más utilizadas, el 82% se clasifica como de riesgo «medio», «alto» o «crítico».

- Un tercio de los empleados accede a las herramientas GenAI desde cuentas personales, lo que aumenta el riesgo general y la IA en la sombra.

- Los empleados suministran datos confidenciales a las herramientas de IA, ya que más de un tercio (39,7%) de todas las interacciones con herramientas de IA involucran datos confidenciales.

La siguiente distribución muestra el marcado aumento del número de herramientas GenAI en uso entre las empresas que las adoptan con mayor agresividad.

“Las organizaciones deben comprender y rastrear el ciclo de vida completo de los datos para protegerlos adecuadamente”, instó Doshi.

Brecha fronteriza: ¿Estrategia o cultura permisiva?.

Es muy probable que las organizaciones fronterizas estén implementando una estrategia corporativa oficial que anima a los empleados a incorporar la IA en su flujo de trabajo diario, sugirió Doshi. Este estímulo genera una cultura interna más permisiva hacia la experimentación con nuevas funciones y tecnologías de IA, autorizadas o no.

“Las empresas rezagadas se ven frenada principalmente por una postura de seguridad centrada en los bloques y sistemas de datos heredados fragmentados que hacen que la integración oficial sea demasiado arriesgada o compleja”, afirmó.

También influye una falta de confianza inherente. Estas organizaciones carecen de plena confianza en que sus empleados utilicen estas herramientas de forma segura o acorde con los valores de la empresa.

“Esto crea una brecha donde los líderes de estas organizaciones ven la IA como una amenaza que debe gestionarse. Las empresas fronterizas la ven como un motor de productividad que puede habilitarse de forma segura”, añadió.

Los modelos chinos de IA se incorporan rápidamente a la empresa.

Un sorprendente cambio en el equilibrio de poder de la IA muestra que los modelos chinos de peso abierto están pasando de ser ajenos a convertirse en elementos esenciales de la empresa casi de la noche a la mañana. Productos como DeepSeek están impulsando un aumento asombroso en el uso de la IA basada en endpoints.

Este aumento se produce tras el lanzamiento de DeepSeek-R1 en enero de 2025, que demostró que China podía igualar —y, en tareas específicas como la codificación, incluso superar— los modelos fronterizos estadounidenses, según Doshi. Para muchos empleados, el atractivo de un rendimiento superior y la facilidad para eludir los filtros corporativos superan la cautela geopolítica. Estos factores crean una huella masiva y sin supervisión del silicio chino en las redes occidentales.

“Las capacidades comparables de estos modelos, combinadas con la tendencia de LMArena a proporcionar modelos de ponderación abierta, han llevado al 50% del uso basado en endpoints”, confirmó.

Trabajadores inconscientes exponen datos confidenciales.

Como se mencionó anteriormente, un alarmante 39,7% de las interacciones involucran datos sensibles. Al menos una parte de esto se debe a que los empleados suben a sabiendas información confidencial, como el código fuente. Esto también provoca errores de confidencialidad involuntarios cuando los usuarios integran herramientas de IA en flujos de trabajo estándar como CRM e I+D.

“La IA es una tecnología relativamente nueva, y los empleados no comprenden completamente lo que significa introducir datos sensibles en un sistema de IA. Esto significa que sus datos ya no están bajo control corporativo y ahora residen en un proveedor de IA”, afirmó Doshi.

Peor aún, algunos de estos proveedores entrenan sus modelos con datos proporcionados por los usuarios. Sin embargo, añadió, para los empleados puede que no esté claro qué constituye información sensible ni cómo funciona la IA.

Por lo tanto, la falta de concienciación sobre seguridad entre los empleados es un problema importante en el uso de la IA empresarial. Además, esta falta de concienciación es una de las razones por las que muchas organizaciones dudan en fomentar el uso de la IA, optando por una política de «bloqueo prioritario», explicó.

Cuentas personales: un culpable oculto.

El 60% del uso de Claude y Perplexity se realiza a través de las cuentas personales de los empleados. Esto contribuye a que Shadow AI supere a las herramientas corporativas autorizadas en experiencia de usuario y utilidad.

Claude y Perplexity son casos extremos, ya que son herramientas especializadas. Los usuarios adoptan ampliamente a Claude como el mejor programador, y Perplexity es un motor de búsqueda de IA diseñado específicamente para ello.

«Creo que la gente usa Claude y Perplexity específicamente para estos fines, respectivamente, ya que ofrecen una mejor experiencia de usuario que las herramientas corporativas autorizadas», comentó Doshi.

Coincidió en que Shadow AI es, en general, un problema creciente, ya que las herramientas de IA pueden procesar información confidencial a la velocidad de una máquina. Las copias derivadas de los datos más valiosos de una organización pueden proliferar rápidamente fuera del control central.

“Combatir esto requiere una seguridad y gobernanza de datos robustas”, afirmó.

Aplicaciones GenAI: Un Negocio de alto riesgo.

El informe clasificó el 82% de las 100 principales aplicaciones GenAI como de «Alto Riesgo». Sin embargo, según Doshi, esto no significa que el mercado actual de IA empresarial no ofrezca las funciones específicas que necesitan los empleados.

La siguiente gráfica desglosa los niveles de riesgo entre las herramientas GenAI SaaS más utilizadas.

El alto porcentaje de aplicaciones riesgosas se debe a que los empleados priorizan la accesibilidad sin complicaciones sobre los canales oficiales. Muchas de estas aplicaciones de nicho ofrecen flujos de trabajo especializados que no requieren experiencia previa, lo que permite a los trabajadores evitar la curva de aprendizaje.

Tomemos como ejemplo NoteGPT. Ofrece un resumidor, transcriptor, conversor de PDF y escritor de IA listos para usar.

“Además, muchas herramientas empresariales nuevas que prometen seguridad e innovación a menudo carecen de las capacidades de las herramientas creadas y publicadas por desarrolladores, o incluso de herramientas GenAI más básicas como Claude”, advirtió Doshi.

El fin del chatbot y más allá.

La transición hacia agentes integrados y herramientas de codificación marca el comienzo de una nueva era. El chatbot de IA independiente, con su interfaz similar a ChatGPT, podría estar ya en su apogeo, reemplazando a la IA invisible e integrada.

Sin embargo, Doshi cree que es demasiado pronto para afirmarlo con certeza. Los investigadores solo observan un estancamiento en la adopción de aplicaciones de IA, mientras que los agentes de codificación de IA especializados siguen creciendo.

“En lugar de considerarlo un declive de los chatbots, diría que algunas herramientas de IA, como los agentes de codificación, han realizado un excelente trabajo al aplicar la IA a dominios especializados y, por lo tanto, están recibiendo el reconocimiento de sus usuarios, lo que impulsa su crecimiento”, sugirió.

Los datos muestran que el uso de la IA es más frecuente entre los ingenieros. Doshi argumentó que es lógico que recurran a herramientas de programación y agentes integrados para sus flujos de trabajo diarios, en lugar de que un empleado de marketing necesite una herramienta GenAI para tareas básicas y puntuales.

¿Qué viene después con la IA en el lugar de trabajo?.

Según Doshi, el uso de la IA, autorizada o no, seguirá aumentando. El número de aplicaciones de IA utilizadas y el porcentaje de empleados que las utilizan serán puntos de referencia sólidos para las empresas que han adoptado la IA o planean hacerlo para impulsar mejoras estratégicas de productividad.

Algunos se refirieron a 2025 como el Año de los Agentes de IA. Si bien es parcialmente cierto, Doshi predice que más empresas desarrollarán y adoptarán agentes de IA en los próximos años.

«Esto es solo el comienzo, por lo que asegurar y gestionar estas herramientas es crucial», instó.