Una charla informal de AMD, solo por invitación, para analistas del sector el mes pasado tuvo un ambiente renovador, lo que indicaba que la empresa ya no piensa en silos de productos. La charla describió a AMD como un negocio de tres pilares que abarca centros de datos, productos para el usuario final y productos integrados.

Esto es importante porque la IA ya no es un mercado único; es una pila y un patrón de implementación. La línea más interesante de la discusión quizás haya sido la descripción más simple de dónde se ubica la IA en esa pila: la nube es para la escala, el edge es para la inmediatez, los dispositivos para la intimidad.

Esa es una forma creativa de describir cómo AMD ha evolucionado en los últimos años, y sin duda en 2025, hasta convertirse en una empresa capaz de vender con credibilidad soluciones de computación, desde clústeres de entrenamiento hasta inferencia en el edge y PC con IA integrada en el dispositivo.

A finales de la década de 1990 y gran parte de la década de 2000, AMD parecía a menudo preparada para inventar grandes productos, pero tuvo dificultades para ejecutarlos al ritmo y la consistencia que demandaba el mercado. Había brechas de ejecución persistentes, ventanas de tiempo perdidas y un seguimiento desigual de la plataforma; basta con preguntarles a Compaq o Dell en esa época. El escepticismo del mercado era palpable, como puedo atestiguar de primera mano, habiendo trabajado en Compaq y Dell durante los tiempos difíciles de AMD.

Hoy, el tono es diferente. No porque la competencia haya disminuido, sino porque la cultura de AMD, desde la llegada de la CEO Lisa Su, ha sido mucho más disciplinada en cuanto a hojas de ruta, colaboraciones y entrega sostenida.

Una de las razones por las que surgió la conversación es que AMD describe abiertamente el «cómo», no solo el «qué».

Salil Raje, vicepresidente sénior y director general de Computación Adaptativa e Integrada de AMD, lo expresó claramente: AMD «no era tradicionalmente una empresa de software», pero ha «dirigido nuestra atención al software» con ROCm y un impulso explícito para ser «más amigable con el código abierto» para que la comunidad de desarrolladores pueda trabajar con él a escala.

ROCm y la cuestión de la plataforma.

Esto representa un cambio sutil pero significativo con respecto a la antigua AMD. El viejo manual se apoyaba en un chip de sonido y esperaba que el ecosistema siguiera su ejemplo. La IA ha enseñado a toda la industria que el ecosistema debe ser diseñado, financiado y respaldado de forma obsesiva. AMD ahora habla como una empresa que entiende esa regla.

Durante la llamada, Raje afirmó que AMD intentaba que ROCm se percibiera menos como un conjunto de herramientas exclusivo para centros de datos y más como una capa unificadora en todo su portafolio.

En una sección sobre flujos de trabajo locales de IA, el ponente describe ROCm como una «pila unificada» «compuesta principalmente por software de código abierto», que abarca desde kernels de bajo nivel hasta aplicaciones de usuario final de alto nivel», y cuyo objetivo es acelerar las cargas de trabajo «sin problemas entre nuestra infraestructura en la nube, centro de datos y dispositivos personales».

Esa es la ambición correcta. Y es también donde AMD aún tiene algo que demostrar. Nvidia cuenta con años de experiencia en desarrollo detrás de CUDA. AMD goza de un gran impulso, pero el mercado juzgará en última instancia ROCm en función de los detalles de la última milla: la fricción de la instalación, la paridad del marco, la madurez del zoo de modelos (la amplitud, calidad y disponibilidad para producción de los modelos compatibles), la estabilidad del rendimiento y la rapidez de las soluciones cuando algo falla.

Aun así, los anuncios de AMD para 2025 muestran una transición de una empresa de proveedor de componentes a un participante en la infraestructura, que es lo que exigen los centros de datos de IA.

Todo gira en torno al centro de datos de IA.

2025 fue un año transformador para AMD, especialmente en sus alianzas estratégicas. Se formaron importantes alianzas que podrían definir el futuro de la infraestructura de IA, en particular el acuerdo de la empresa con OpenAI y HPE sobre la arquitectura a escala de rack Helios.

El acuerdo con OpenAI es especialmente destacable. AMD y OpenAI firmaron un acuerdo plurianual según el cual OpenAI desplegará hasta 6 gigavatios de GPU AMD Instinct, comenzando con 1 gigavatio de GPU Instinct MI450 en el segundo semestre de 2026, e incluirá trabajo técnico conjunto para alinear las hojas de ruta. En el ámbito comercial, AMD también emitió a OpenAI una garantía vinculada a hitos de despliegue y escalado, lo que demuestra tanto compromiso como responsabilidad.

Además, está la narrativa del escalado en la nube, que cada vez se define más como «escala de rack, no solo GPU». Por ejemplo, Oracle planea lanzar un superclúster de IA disponible públicamente, impulsado por 50.000 GPU de la serie Instinct MI450 en el tercer trimestre de 2026, utilizando la arquitectura de rack Helios con CPU EPYC Venice de última generación y redes Pensando Vulcano.

Vultr, que ofrece servidores privados virtuales (VPS) asequibles y de alto rendimiento para desarrolladores y empresas, planea construir un superclúster de IA de 50 MW en Ohio, impulsado por 24 000 GPU Instinct MI355X, con planes para integrar MI450 y Helios.

Además, AMD amplió su colaboración con HPE en torno a Helios, prometiendo conectividad a escala de rack de alto ancho de banda y baja latencia. Este es el cambio fundamental de una empresa tradicional de procesadores básicos a un competidor en el mercado de los centros de datos de IA. No se trata de una sola GPU. Se trata de CPU, GPU, redes, diseño de sistemas y software.

AMD también está utilizando la historia de la integración para recordarnos que la próxima ola de crecimiento de la IA no se limitará a los centros de datos de hiperescala.

Raje describió la capacidad de AMD para pasar de la nube al edge y a los endpoints y la combinó con una importante promesa de mercado: un TAM de infraestructura de IA de aproximadamente un billón de dólares en 2030, con expectativas de crecimiento de ese mercado a una tasa de crecimiento anual compuesta (TCAC) del 80% durante los próximos tres a cinco años. Posteriormente, se centró en la IA integrada y física, argumentando que el próximo punto de inflexión será «cuando la IA pase de la nube al mundo físico», con miles de millones de dispositivos y un TAM de 200.000 millones de dólares para 2035.

La cadencia de éxito en el diseño del grupo integrado se presenta como prueba de la confianza del cliente y la visibilidad a largo plazo, incluyendo aproximadamente 16.000 millones de dólares en éxitos de diseño en 2025.

Independientemente de si se aceptan todas las cifras, el punto estratégico sigue siendo sólido: la compañía busca ser relevante en todas las capas de la implementación de la IA, no solo en los glamurosos clústeres de entrenamiento.

Anuncios tibios de AMD en el CES 2026.

Entonces, ¿dónde encajan los planes de AMD en el CES en este avance más amplio de la IA?.

Aunque esto pueda parecer poco entusiasta, los anuncios de AMD en el CES parecieron ser una continuación de su estrategia actual, más que un cambio inesperado.

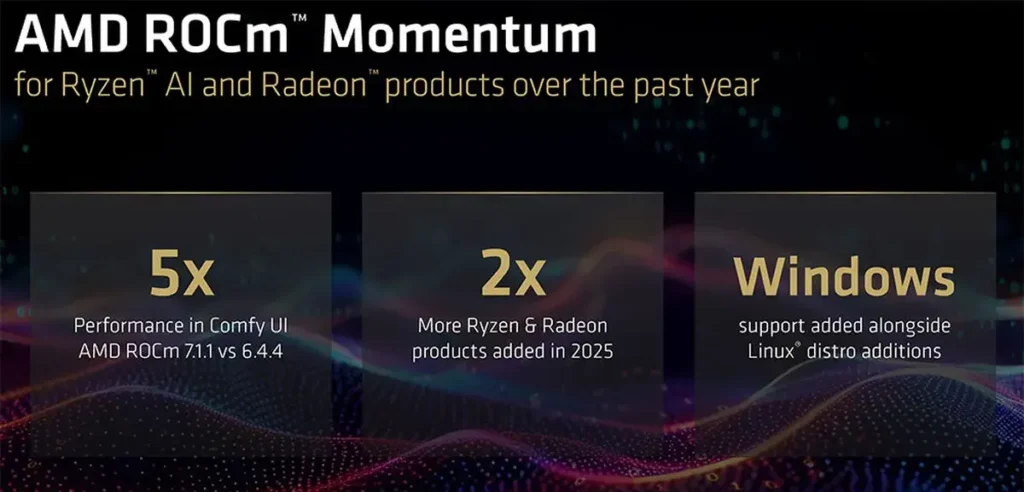

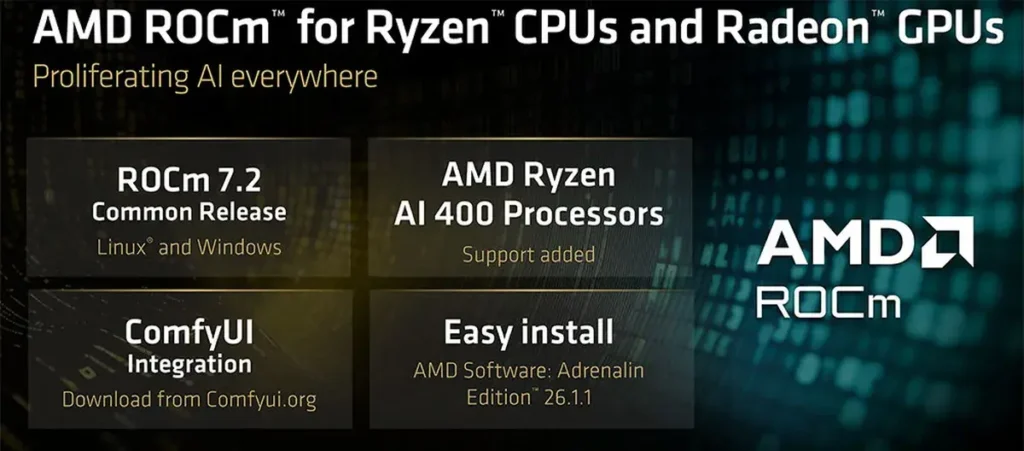

ROCm 7.2 llega este mes para Radeon y Ryzen en Windows y Linux, con nueva compatibilidad con los procesadores Ryzen AI 400 e integraciones como Comfy UI.

En el sector de los videojuegos, AMD afirma estar ampliando el portafolio Ryzen 9000 X3D e impulsando FSR Redstone en sus tarjetas de la serie RX 9000, con promesas como un rendimiento de «hasta 4,7x» en un ejemplo de trazado de rayos. Esto mantendrá a AMD muy visible en el sector de los videojuegos y reforzará una fortaleza que ha estado en el ADN de AMD durante años.

Pero, francamente, estos anuncios parecen ser en gran medida graduales, reflejando la ejecución de un anuncio de hoja de ruta establecido, más que un cambio radical.

Siendo realistas, las empresas que buscan ese momento mágico en el CES que redefina las expectativas de toda la industria suelen necesitar el anuncio de una plataforma completamente nueva o de un nuevo ecosistema.

Lo que AMD anunció en el CES es innegablemente importante y, de hecho, venderá unidades reales. Simplemente no parece cambiar la física competitiva de la noche a la mañana. La mayor historia de la IA de AMD, la que podría cambiar la física, está ocurriendo en las alianzas de centros de datos y los sistemas a escala de rack que comienzan a implementarse en 2026.

Posicionamiento de AMD en 2026.

Esto me lleva a la perspectiva equilibrada que veo para 2026.

Como aspecto positivo, AMD se ha posicionado para participar en la siguiente fase del desarrollo de la infraestructura de IA de una manera que no podría haberlo hecho hace unos años. El despliegue de OpenAI comienza en la segunda mitad de 2026. Oracle prevé el tercer trimestre de 2026 para su supercúmulo impulsado por MI450. La empresa conjunta Human prevé una primera fase prevista para 2026 como parte de una hoja de ruta más amplia de 1 GW. Estos no son experimentos pequeños. Son apuestas a escala de sistema.

En cuanto al riesgo, 2026 es cuando la ejecución se hace visible, y la visibilidad es un arma de doble filo. Las verdaderas pruebas son sencillas:

- ¿Puede AMD ofrecer plataformas de clase MI450 con los volúmenes y la fiabilidad que esperan los clientes?.

- ¿Podrá mantener la mejora de ROCm lo suficientemente rápida como para que los desarrolladores sientan confianza, no curiosidad?.

- ¿Podrá lograr que las redes basadas en Helios y Pensando se perciban como una alternativa coherente a una «fábrica de IA» en lugar de un conjunto de componentes?.

- ¿Podrá AMD hacer todo eso mientras Nvidia sigue cambiando los estándares con un ritmo implacable, ya que sin duda no se quedará quieta?.

Aun así, me enfrento a esta persistente pregunta después de analizar lo que AMD ha logrado en 2025 y con la vista puesta en 2026: ¿AMD intenta triunfar en IA fabricando el mejor chip único o creando la plataforma más adoptable?.

Las conversaciones con ejecutivos de AMD, tanto en la cadena de mando como en los niveles inferiores de la compañía, sugieren esto último. Se habla de «fábricas de IA», soluciones a escala de rack como Helios y software que abarca desde la nube hasta los dispositivos personales.

En mi opinión, esa es precisamente la lección correcta de la propia historia de AMD. En los años más difíciles, AMD a menudo necesitaba un producto rompedor para compensar la menor gravedad de la plataforma. Bajo el liderazgo de Lisa Su, la compañía ha construido cada vez más sistemas sostenibles en torno a su silicio. Su lista de socios para 2025 parece una continuación de esa estrategia.

Si 2026 cumple con la primera ola de estos despliegues, AMD se verá menos como un proveedor alternativo y más como una parte estructural del mercado de centros de datos de IA. Si tropieza, lo cual no espero, el mercado no será paciente, porque los clientes de IA no compran con esperanza. Compran resultados predecibles.

El excelente desempeño de AMD en 2025 sugiere que comprende esa realidad. Más que cualquier gráfico de referencia, esa comprensión es la señal más clara de lo lejos que ha llegado la empresa y de con qué decisión ha superado los problemas de ejecución de finales de los años 1990 y principios de los años 2000.